· Andreas Schwarz · Trends & Impulse · 9 min read

Retrieval-Augmented Generation - Unternehmenswissen in der Praxis

Retrieval-Augmented Generation verbindet externe Wissensquellen mit generativer KI und schafft neue Ansätze für unternehmensrelevante Wissensarbeit und effiziente Entscheidungsfindung.

Teaser

Retrieval-Augmented Generation (RAG) verknüpft KI mit externen Datenquellen und hebt die Qualität unternehmensbezogener Texte und Analysen auf ein neues Level. Für Entscheider bietet RAG Chancen, maßgeschneiderte KI-Anwendungen sicher, transparent und faktenbasiert einzuführen. Lesen Sie, wie Unternehmen von RAG profitieren können, worauf bei der Implementierung zu achten ist und welche Handlungsoptionen für eine strategische Nutzung bestehen.

Retrieval-Augmented Generation - Potenziale, Praxis und Perspektiven für Unternehmen

Wie RAG die Nutzung von KI in Unternehmen verändert

Um aktuelle Herausforderungen rund um Informationsverfügbarkeit, Datenintegration und inhaltliche Präzision zu meistern, setzen immer mehr Unternehmen auf KI-Systeme mit Zugang zu externem Wissen. Retrieval-Augmented Generation (RAG) steht dafür, Large Language Models (LLMs) mit einer zielgerichteten Recherche-Komponente zu verbinden. Damit können Unternehmen sowohl auf ihre eigenen Daten als auch auf externe Wissensquellen zurückgreifen - und so signifikant bessere, nachvollziehbarere Ergebnisse erzielen. Für Entscheider eröffnet RAG neue Handlungsoptionen: Information wird schneller, spezifischer und systematischer verfügbar. Gleichzeitig entstehen jedoch neue Anforderungen an Technologie, Organisation und Risikomanagement. Eine differenzierte Bewertung dieser Technologie ist deshalb elementar für eine nachhaltige KI-Strategie.

RAG verstehen: Definition, Abgrenzung und Marktentwicklung

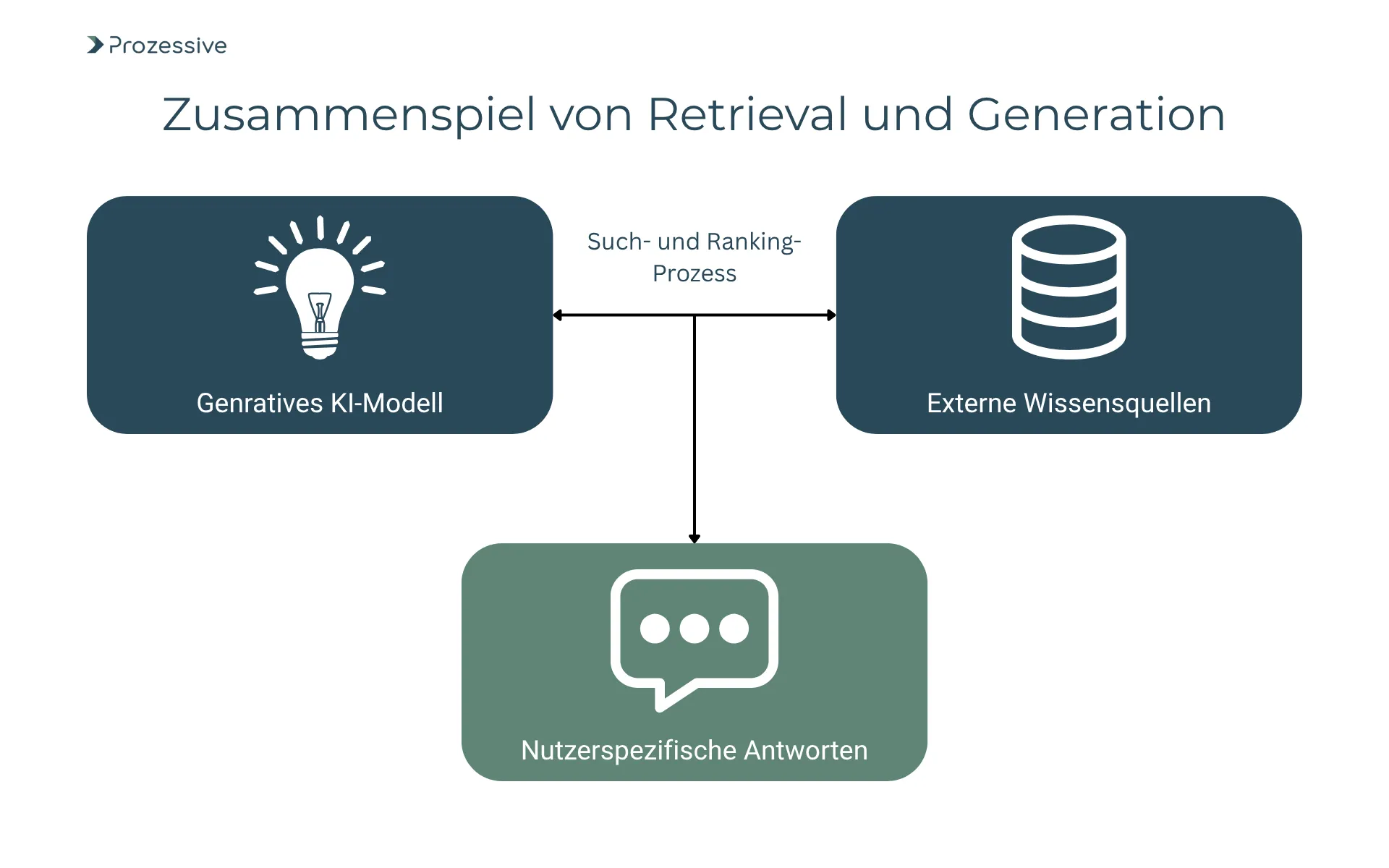

Retrieval-Augmented Generation bezeichnet das Prinzip, generative KI-Modelle gezielt mit externen Datenquellen zu koppeln. Während gewöhnliche Sprachmodelle (LLMs) nur auf das Wissen aus dem Trainingsdatensatz zugreifen können, holen RAG-Systeme zur Beantwortung einer Anfrage aktiv Inhalte aus definierten Dokumentensammlungen, Datenbanken oder dem Web ein. Diese Inhalte werden - meist über Such- und Ranking-Algorithmen - ausgewählt und der generativen Komponente zur Verfügung gestellt, die daraus wiederum kontextbezogene, strukturierte Antworten generiert.

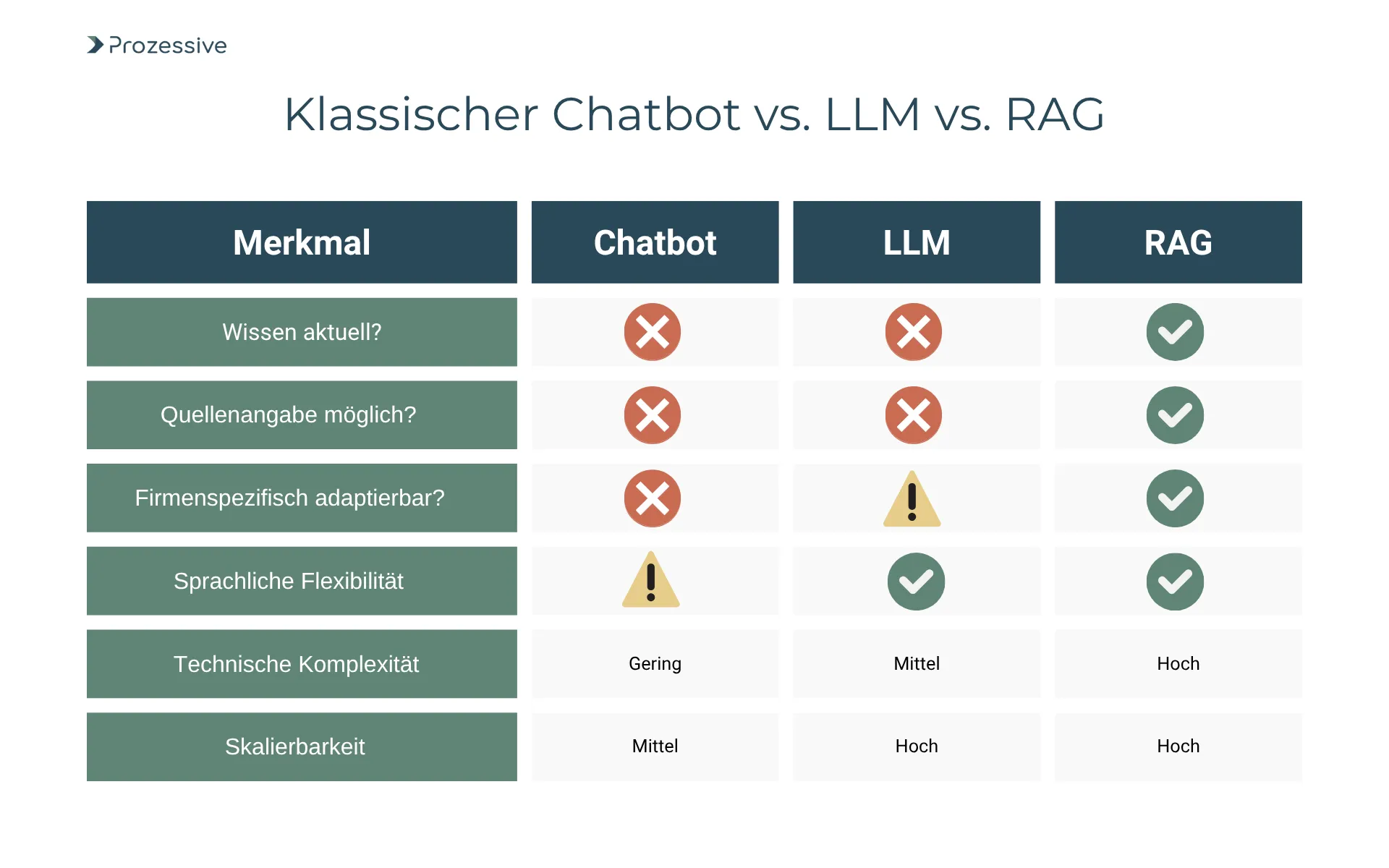

Der Unterschied zu herkömmlichen KI-Anwendungen und Chatbots liegt somit in der Lebendigkeit und Breite des verwendbaren Wissens. Klassische Chatbots basieren meist auf statischen Regeln oder einfachen FAQ-Bäumen mit begrenzter Inhaltstiefe. Auch Standard-LLMs (wie GPT-3/4, Stand: 2024) generieren zwar kreative und sprachlich ansprechende Texte, sind aber auf den gelernten Datenstand beschränkt und können aktuelle oder firmenspezifische Sachverhalte kaum einbeziehen. RAG erweitert dieses Spektrum entscheidend, indem systematisch recherchierte, aktuelle Informationen direkt in die Antwort einfließen. Dadurch können beispielsweise unternehmensinterne Wissensdatenbanken, Richtlinien oder Echtzeit-Marktberichte in NLP-Anwendungen integriert werden.

Die Marktentwicklung spiegelt diese Dynamik wider. Zahlreiche Anbieter - von Cloud-Giganten bis KI-Startups - positionieren sich mit RAG-Tools, Schnittstellen und Services. Laut einer Erhebung von Gartner (2024) wird der Anteil von Unternehmens-KI-Anfragen, die explizit auf eigene Dokumentenbestände zugreifen, in den nächsten zwei Jahren auf über 40% steigen. Für Entscheider rückt damit die Evaluierung und Integration von RAG-Lösungen zunehmend in den Fokus strategischer Digitalisierungsinitiativen.

Abschließend steht fest: RAG ist keine Modeerscheinung, sondern eine substanzielle Weiterentwicklung, die Unternehmen jeglicher Größe dazu befähigt, für sie relevante Informationen gezielt, nachvollziehbar und automatisiert zu nutzen.

Geschäftlicher Nutzen und Anwendungsfelder: Wo RAG echten Mehrwert stiftet

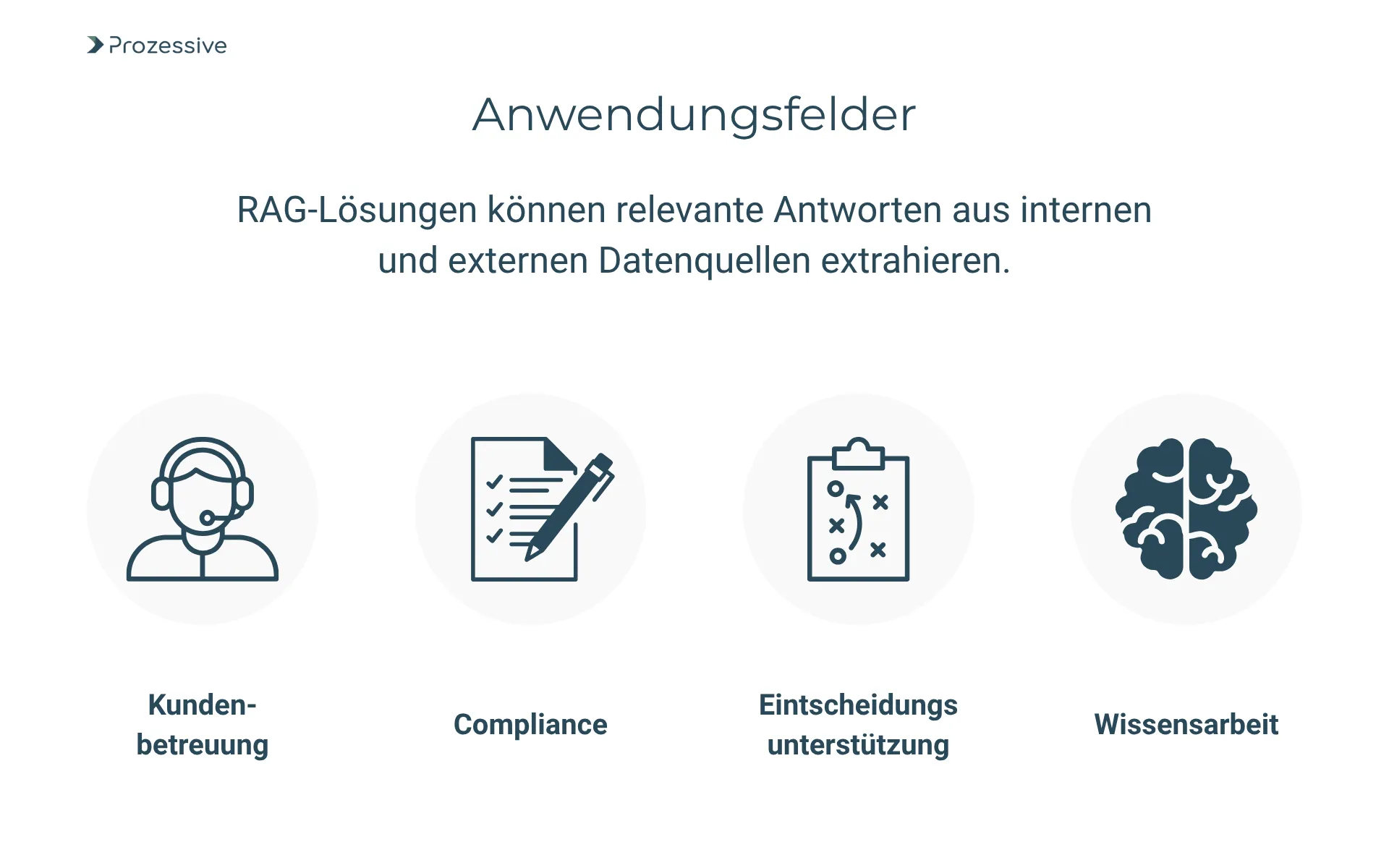

Unternehmensrealitäten werden zunehmend von der Fähigkeit geprägt, relevantes Wissen effizient zu erschließen und in Entscheidungen einzubinden. RAG-Lösungen gehen genau an dieser Schlüsselstelle einen Schritt weiter und bieten in diversen Branchen und Anwendungsbereichen messbaren Mehrwert. Durch die Verbindung von externen und internen Quellen lässt sich die Präzision automatisierter Antworten signifikant steigern - ein Hebel, der sich entlang der gesamten Wertschöpfungskette bemerkbar macht.

In der Kundenbetreuung lassen sich Supportprozesse durch RAG-systeme massiv beschleunigen. Statt mit statischen FAQ-Systemen zu arbeiten, können moderne Chatbots sowohl auf historische Tickets, interne Wissensdatenbanken als auch auf aktuelle Produktinformationen zugreifen. Unternehmen berichten laut einer McKinsey-Studie (2024) von Reduktionen bei der durchschnittlichen Fallbearbeitungszeit um bis zu 35% sowie spürbaren Verbesserungen in der Kundenzufriedenheit (NPS-Steigerung um 15-20 Punkte). Durch die Kontextintegration können selbst komplexe oder individuelle Kundenfragen automatisiert und zuverlässig beantwortet werden.

Im Compliance-Bereich ist die Adaption von RAG ein entscheidender Fortschritt. Regulatorische Dokumentationen ändern sich häufig; Standards wie DSGVO, BaFin oder Branchenvorgaben erfordern eine tiefgehende, aktuelle Recherche. RAG-gestützte Compliance-Chatbots ermöglichen Fachabteilungen, auf Anfragen sofort und mit Verweis auf konkrete Richtlinien zu reagieren. Fehlerquellen und Zeitverluste durch manuelle Recherche sinken deutlich. PwC-Analysen (2023) zeigen: Unternehmen konnten in Pilotprojekten die Bearbeitungsdauer von Compliance-Anfragen halbieren und falsch-positive Meldungen um ein Drittel senken.

Ein weiterer relevanter Use-Case ist die datengetriebene Entscheidungsunterstützung. F&E-Teams lassen sich bei der Sichtung neuester wissenschaftlicher Veröffentlichungen von RAG-Lösungen assistieren, indem relevante Publikationen aus globalen Datenbanken in die Bewertung einbezogen werden. Ebenso profitieren Produktmanagement und Business Development von der Integration von Marktforschungsberichten, Patenten oder Wettbewerbsanalysen. Dies unterstützt nicht nur die Geschwindigkeit der Entscheidungsfindung, sondern sorgt für substantielle Qualitätsgewinne - belegt durch Studien wie von Forrester (2024), die eine durchschnittliche Beschleunigung von Innovationsprozessen um 20‑30 % durch den gezielten RAG-Einsatz nachweisen.

RAG steigert somit nicht nur die Geschwindigkeit der Wissensarbeit, sondern reduziert zugleich Fehlerquellen, erhöht die Transparenz der Antworten und ermöglicht echte Skalierung. Das wirkt sich auf Kostenstrukturen, Kundenbindung und Innovationskraft gleichermaßen aus. Zugleich bleibt zu bedenken, dass die Einführung nicht frei von Herausforderungen ist - insbesondere bei hoher Datenkomplexität, sensiblen Inhalten und fehlenden Integrationsstrukturen.

Voraussetzungen für eine erfolgreiche RAG-Implementierung

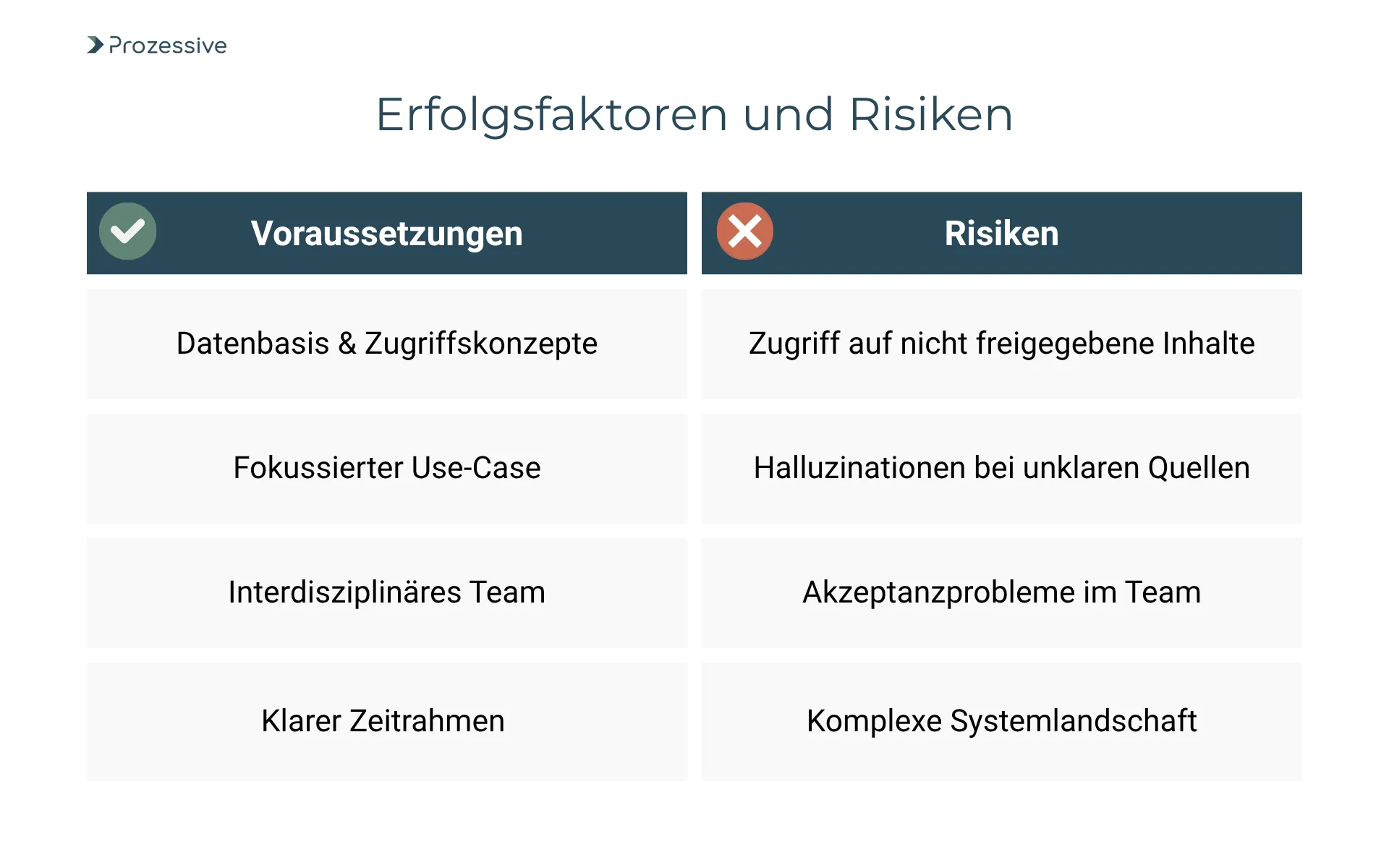

Eine nachhaltige RAG-Einführung setzt ein Zusammenspiel technischer, organisatorischer und rechtlicher Voraussetzungen voraus. Unternehmen sollten zunächst klären, welche Datenquellen angebunden werden sollen und wie deren Qualität, Aktualität und Struktur beschaffen sind. Bestehende Daten müssen für eine semantische Suche aufbereitet (Stichwort: Indexierung und Metadatenmanagement) und Zugriffsrechte sauber geregelt werden. Häufig sind Vorarbeiten im Bereich der Datenbereinigung, -klassifizierung und -sicherheit nötig, um einen reibungslosen Einstieg zu ermöglichen.

Technisch ist eine leistungsfähige IT-Infrastruktur erforderlich, die sowohl die Verarbeitung großer Datenmengen als auch sichere Schnittstellen zu LLMs und Anfragesystemen bereitstellt. Cloud-Anbieter wie Microsoft, Google oder AWS bieten entsprechende Standardmodule, anpassbare Frameworks und Managed Services, allerdings bleibt die Integration in bestehende ERP-, CRM- und DMS-Landschaften oft anspruchsvoll.

Organisatorisch ist die Zusammenarbeit von Fachbereich, IT und Datenschutz notwendig. Die Verantwortung für Datenpflege und -freigabe sollte klar definiert werden. Fachkräfte mit Kompetenzen in KI, Datenbanken und Prozessmanagement sind unabdingbar - laut Bitkom (2024) fehlt es hier vielen Unternehmen weiterhin an Erfahrungswissen. Rechtlich müssen insbesondere Vorgaben zu Datenschutz (DSGVO), Urheberrecht und Dokumentationspflicht gehandhabt werden. Die protokollierte Nachvollziehbarkeit der von der KI genutzten Quellen ist nicht nur für Auditierungen, sondern auch für die Akzeptanz in der Belegschaft entscheidend.

Pilotprojekte mit klar fokussiertem Use-Case und begrenztem Datenumfang haben sich als sinnvolle Einstiegsoption bewährt. Die typische Zeitspanne für initiale Piloten liegt - je nach Integrationstiefe - bei 3 bis 6 Monaten. Für einen flächendeckenden Rollout ist ein Zeitraum von 9 bis 18 Monaten realistisch, jeweils abhängig von Systemlandschaft, Datenlage und eingesetzten Ressourcen. Stolpersteine entstehen vor allem bei heterogenen Datenquellen, fehlender Dokumentation, zu hohen Datenschutzanforderungen und Schnittstellendefiziten.

Eine frühzeitige Klarstellung der Ziele, proaktive Klärung der rechtlichen Rahmenbedingungen und gemeinsames Projektvorgehen zwischen IT und Fachbereich erhöhen die Erfolgswahrscheinlichkeit spürbar.

Risiken, Herausforderungen und nachhaltige Integration

RAG eröffnet große Potenziale, bringt aber auch konkrete Risiken und Herausforderungen. Datenschutz bleibt ein zentrales Thema: Werden personenbezogene Daten verarbeitet, greifen strenge regulatorische Anforderungen. Die Auswahl, Speicherung und Nutzung von Informationsquellen muss daher klar geregelt und protokolliert werden. Vermeintlich triviale Fehler - etwa Zugriff von LLMs auf nicht freigegebene Dokumente - ziehen schnell ernsthafte Konsequenzen nach sich.

Ebenfalls kritisch ist der Umgang mit fehlerhaften, veralteten oder verzerrten Datenquellen. Werden ungenaue Informationen zur Wissensgenerierung herangezogen, kann dies zu falschen oder inkonsistenten Antworten führen - mit weitreichenden Folgen für Compliance, Kundenkommunikation und strategische Weichenstellungen. Hierfür ist einerseits ein wirksames Datenqualitätsmanagement, andererseits eine klare Dokumentation der zugrundeliegenden Quellen und Logik erforderlich. Hinzu kommen Herausforderungen der Algorithmustransparenz: Nutzer und Auditverantwortliche müssen nachvollziehen können, wie und warum bestimmte Informationen gewählt worden sind.

Ein weiteres Risiko liegt im Fachkräftemangel. Der Markt für KI-Expertinnen und Experten ist weiterhin angespannt. Fehlendes Know-how behindert Aufbau und Betrieb von RAG-Lösungen, insbesondere bei anspruchsvoller Integration und Governance. Hier kann die Zusammenarbeit mit spezialisierten Dienstleistern oder gezielter Aufbau interner Kapazitäten sinnvoll sein.

Empfohlene Strategien zur Risikominimierung umfassen einen iterativen Projektansatz mit kontinuierlichem Monitoring, definierte Freigabeprozesse für Datenquellen, umfangreiches Testen gegen „Edge Cases“ sowie den Aufbau von Supportstrukturen für Fachfragen. Begleitende Schulungen und Change-Management-Maßnahmen sorgen für Akzeptanz und nachhaltige Integration in etablierte Prozesse. Zudem kann der Einsatz externer Audit-Module und Compliance-Automatisierung zusätzliche Sicherheit schaffen.

Risiken lassen sich nicht vollständig eliminieren; sie sind jedoch durch methodische Ansätze, realitätsnahe Planung und konsequentes Qualitätsmanagement auf ein akzeptables Niveau begrenzbar.

Ausblick: Reifegrad, Trends und Handlungsempfehlungen für Entscheider

Retrieval-Augmented Generation ist inzwischen ausgereift genug, um für eine Vielzahl von Firmen klare operative und strategische Vorteile zu bieten. Während die Basistechnologien weitgehend etabliert sind, liegen aktuelle Markttrends vor allem in der Domänenspezialisierung, stärkeren Self-Service-Fähigkeit und verbesserten Transparenzfunktionen. Branchen wie Recht, Versicherung und Industrie treiben die Entwicklung voran, während Lösungen für Gesundheitswesen und Verwaltung gerade erst an Fahrt gewinnen.

In den kommenden drei Jahren ist mit weiteren Effizienzgewinnen, umfangreicheren Out-of-the-Box-Angeboten und besseren Tools zur Bewertung von Datenqualität und Ergebnisnachvollziehbarkeit zu rechnen. Marktforscher wie IDC erwarten ein jährliches Wachstum von 20-30 % im RAG-Segment; mittelständische Unternehmen und Großkonzerne investieren gleichermaßen in Pilotierungen und Frameworks zur Integration in bestehende IT-Landschaften.

Für Entscheider ergeben sich daraus mehrere Optionen. Eine pragmatische Evaluierung von RAG-Use-Cases lohnt sich besonders dort, wo Wissensarbeit bisher hoch manuell und fehleranfällig ist. Aufbau interner Kompetenzen, eine partnerschaftliche Auswahl passender Technologieanbieter und der Start mit Pilotprojekten mit klarer Zieldefinition minimieren Risiken. Gleichzeitig ist ein „Abwarten“ im Hinblick auf die endgültige Marktreife vertretbar, wenn aktuell kein zwingender Business Case erkennbar ist. Wichtig bleibt, das Thema auf die strategische Roadmap zu setzen und Know-how im Unternehmen kontinuierlich zu stärken.

Abschließend gilt: Unternehmen, die ihren Umgang mit Wissen, Daten und Kundenschnittstellen grundlegend verbessern wollen, sollten RAG gezielt prüfen und, wo sinnvoll, pilotieren. Die Integration dieser Technologie kann ein entscheidender Schritt zu mehr Effizienz, Transparenz und Innovationskraft sein - bei allen Chancen und Risiken, die es solide auszuloten gilt.