· Andreas Schwarz · Automatisierung & Workflows · 7 min read

Ein Tool mehr ist keine Lösung: Integration statt Insellösung

Integration, BPMN und Workflow-Orchestrierung ersetzen Tool-Wildwuchs und ermöglichen belastbare Prozessautomatisierung mit klarer Steuerung und Compliance.

Teaser

Noch ein Tool löst selten die eigentliche Ursache von Reibungspunkten. Wer Prozessautomatisierung nachhaltig etablieren will, braucht Integration, klare Transparenz und verlässliche Orchestrierung. Dieser Beitrag zeigt, wie Sie Insellösungen vermeiden, regulatorische Anforderungen berücksichtigen und Schritt für Schritt eine robuste End-to-End-Steuerung aufbauen. Sie erhalten konkrete Umsetzungsschritte, passende Architekturprinzipien und messbare Ziele, die Ihnen helfen, schneller zu Entscheidungen zu kommen und Risiken kontrolliert zu reduzieren.

”Ein Tool mehr” ist keine Lösung: Integration statt Insellösung

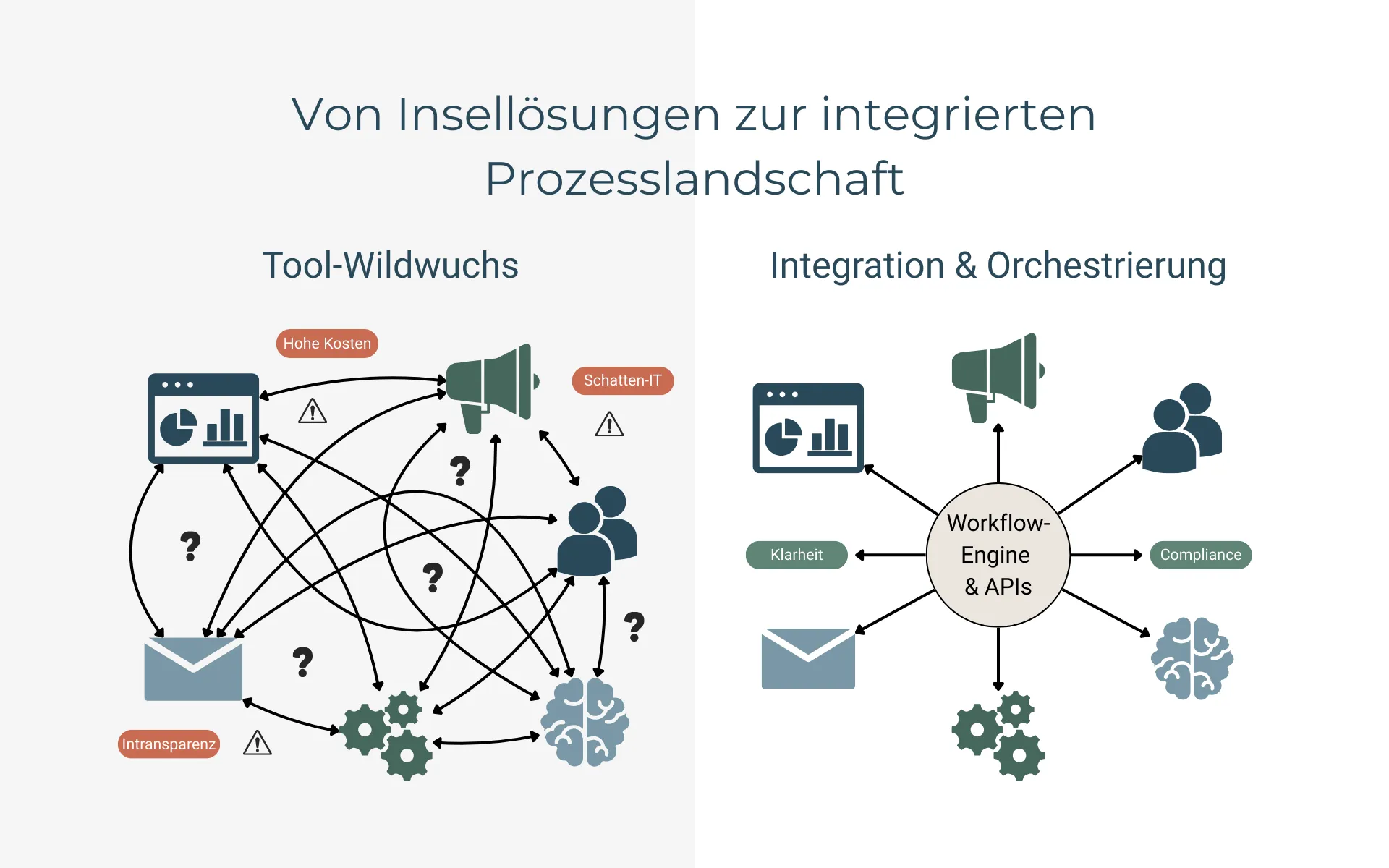

Viele Organisationen sehen sich mit einer wachsenden Zahl von Spezialwerkzeugen konfrontiert. Jedes einzelne löst ein lokales Problem, doch in Summe entstehen Brüche, Mehraufwände und Intransparenz. Für Prozessverantwortliche stellt sich daher nicht die Frage nach dem nächsten Tool, sondern nach einem einheitlichen Vorgehen, das Bestand hat. Der Schlüssel liegt in Integration und Workflow-Orchestrierung statt in der Erweiterung des Werkzeugkastens. Dieser Artikel bietet eine pragmatische Orientierung und adressiert fachliche, technische und regulatorische Anforderungen gleichermaßen.

Warum “ein Tool mehr” selten hilft

Wenn Fachbereiche unter Zeitdruck stehen, ist der Griff zu einer Einzellösung verlockend. Aus lokaler Sicht wirken die unmittelbaren Effizienzgewinne überzeugend. Auf Gesamtunternehmensebene aber häufen sich Medienbrüche, doppelte Datenpflege und Schatten-IT. Ohne Ende-zu-Ende-Sicht steigt die Komplexität, während Governance und Sicherheit hinterherlaufen. In der Folge werden Änderungen teurer und langsamer. Die Betriebskosten verteilen sich unübersichtlich, und Verantwortlichkeiten verschwimmen. Damit wächst das Risiko, regulatorische Pflichten nur punktuell zu erfüllen.

In der DACH-Region verstärken DSGVO, Mitbestimmungsrechte des Betriebsrats und IT-Sicherheitsanforderungen diese Effekte. Unterschiedliche Datenhaltungen erschweren Auskunfts- und Löschkonzepte, fehlende Protokolle gefährden Revisionssicherheit. Punkt-zu-Punkt-Verbindungen sind zwar schnell eingerichtet, werden aber zu einem schwer steuerbaren Netz aus Abhängigkeiten. Der Weg heraus führt über wenige, klare Lösungsprinzipien: standardisierte Schnittstellen, gemeinsame Prozessmodelle und zentrale Steuerung der Abläufe. So entsteht Transparenz als Grundlage für tragfähige Entscheidungen.

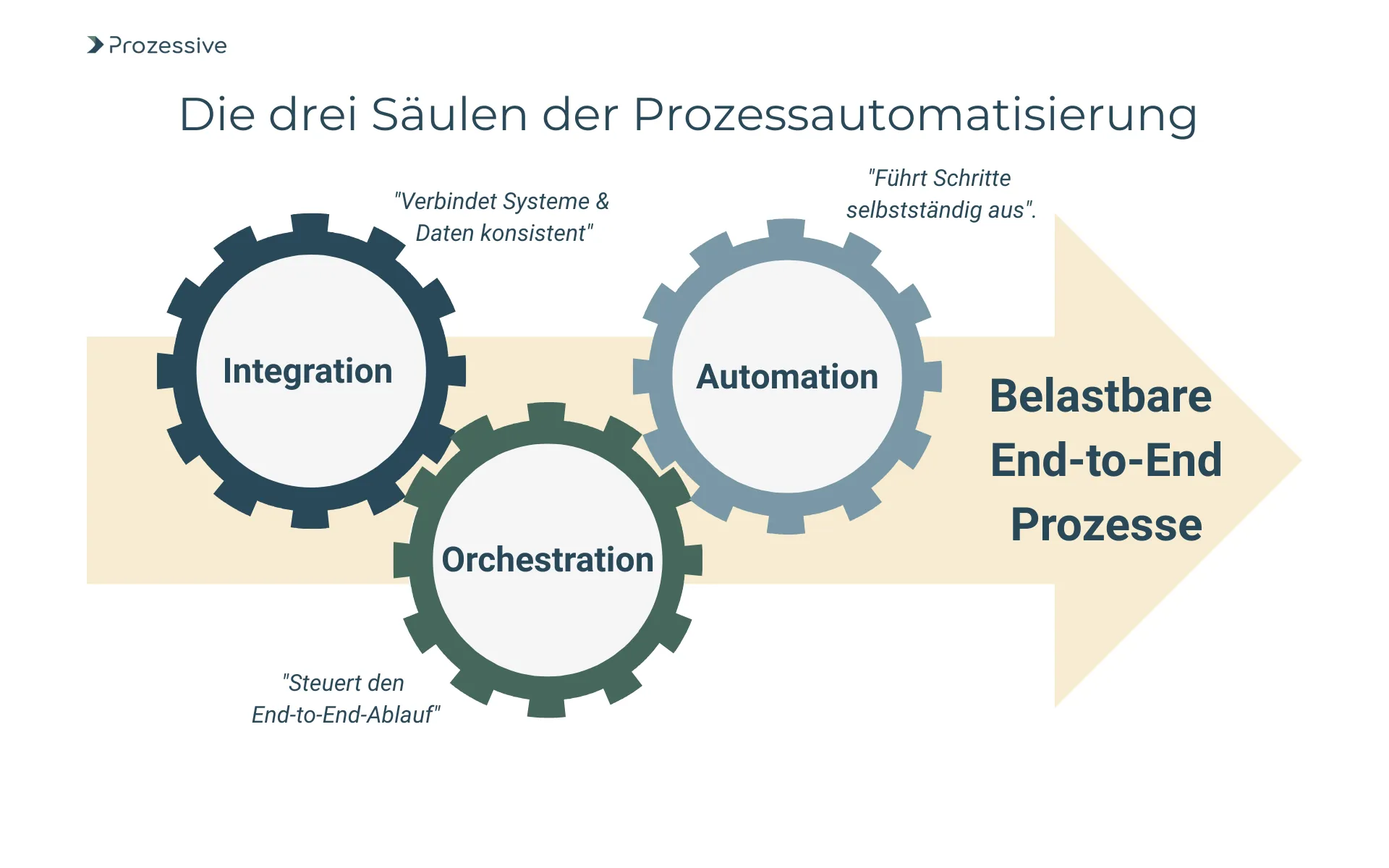

Integration und Workflow-Orchestrierung als Hebel

Integration verbindet Systeme und Daten konsistent, Automatisierung führt Arbeitsschritte ohne manuelle Eingriffe aus, und Orchestrierung steuert den End-to-End-Ablauf über Systemgrenzen hinweg. Eine Workflow-Orchestrierung bündelt Aufgaben, Entscheidungen und Ausnahmen, nutzt wiederverwendbare Services und macht Abläufe sichtbar. Standards wie BPMN schaffen eine gemeinsame fachlich-technische Sprache, die Fachbereich und IT gleichermaßen verstehen. Dadurch werden Abläufe nicht nur ausführbar, sondern auch prüfbar und änderbar.

Integration verbindet, Automatisierung entlastet, Orchestrierung steuert: Gemeinsam entsteht End-to-End-Wert.

Die Abkehr von Punkt-zu-Punkt-Kopplungen hin zu service- und ereignisorientierten Mustern reduziert Abhängigkeiten. APIs, Events und eine Workflow-Engine ermöglichen lose Kopplung und klare Verantwortlichkeiten. Künstliche Intelligenz ergänzt dies gezielt - z.B. bei Klassifikation, Extraktion oder Entscheidungsvorbereitung. Sie ersetzt den Prozess nicht, sondern verbessert die Qualität einzelner Schritte. Wichtig sind Leitplanken: Datenminimierung, Nachvollziehbarkeit der Modelle und ein Betrieb, der Datenschutz und IT-Sicherheit wahrt. So bleibt die Prozessautomatisierung beherrschbar und skalierbar.

Prozessaufnahme und Transparenz als Grundlage

Eine strukturierte Prozessaufnahme schafft die Voraussetzung, Automatisierung zielgerichtet einzusetzen. Mit BPMN lassen sich Schritte, Rollen, Ereignisse und Ausnahmen einheitlich dokumentieren. Dadurch werden Varianten sichtbar, und Engpässe treten offen zutage. Aus der gemeinsamen Sicht entsteht ein tragfähiger Plan: Was wird standardisiert, was wird lokal gelöst, und welche Abhängigkeiten sind zu berücksichtigen. Transparenz ermöglicht, technische und fachliche Diskussionen auf dieselbe Basis zu stellen.

In Deutschland zählen DSGVO, revisionssichere Dokumentation und Mitbestimmung zu den Rahmenbedingungen, die früh berücksichtigt werden sollten. Klären Sie Prozess- und Datenverantwortung, definieren Sie Datenklassifizierungen und Schutzbedarfe, und dokumentieren Sie Einwilligungen und Rechtsgrundlagen. Ergänzen Sie dies um IT-Sicherheitsvorgaben wie Zugriffskontrollen, Protokollierung und Nachweisführung. Ein abgestimmtes Vorgehen mit Datenschutz, Security und ggf. Betriebsrat verhindert späte Korrekturen und verkürzt die Zeit bis zur produktiven Nutzung.

Architekturen, die Insellösungen vermeiden

Eine tragfähige Architektur beginnt mit einer API-Strategie: konsistente Standards, Versionierung, Authentifizierung und Lebenszyklusmanagement. Ereignisgesteuerte Integration reduziert Kopplungen und erlaubt reaktive Abläufe. Eine Integrationsplattform, egal ob On-Premises oder als Dienst, erleichtert die Umsetzung wiederkehrender Muster. So lassen sich Datenflüsse, Fehlerbehandlung und Monitoring zentral gestalten. Das Ergebnis ist weniger Speziallogik und mehr wiederverwendbare Services.

Für die Ausführung eignet sich eine BPMN-Workflow-Engine, die menschliche Aufgaben, Systemaufrufe und Ausnahmen steuert. RPA schließt Lücken, wenn APIs fehlen, sollte aber bewusst als Brücke und nicht als Dauerlösung geplant werden. Ein Daten- und Metadatenkatalog beschreibt Entitäten, Verantwortliche und Zugriffsregeln. Vermeiden Sie ein Geflecht aus direkten Punkt-zu-Punkt-Verbindungen. Nutzen Sie stattdessen klare Muster, die Wachstum und Änderungen verkraften. So bleibt die Automatisierung nachvollziehbar und auditierbar.

Vorgehensmodell zur Prozessautomatisierung

Erfolgreiche Prozessautomatisierung folgt einem klaren Ablauf, der Fachlichkeit, Technik und Governance zusammenführt. Ausgangspunkt ist die priorisierte Prozessaufnahme und die Bewertung nach Nutzen, Komplexität und Risiko. Darauf aufbauend definieren Sie Architekturprinzipien, Datenregeln und Sicherheitsstandards. Ein schlanker End-to-End-Pilot schafft Vertrauen und liefert messbare Ergebnisse. Aus den Erfahrungen entsteht ein belastbares Betriebs- und Supportmodell für die Skalierung.

- Prozesse aufnehmen, Varianten in BPMN dokumentieren, Datenobjekte und Verantwortlichkeiten definieren, Vorbedingungen und Ausnahmen klar benennen.

- Architekturprinzipien festlegen: API-First, Ereignisorientierung, lose Kopplung, Fehler- und Eskalationsmuster, Protokollierung und Observability.

- Regulatorik früh einbinden: Datenschutz-Folgenabschätzung bei sensiblen Daten, Mitbestimmung, Sicherheits- und Freigabeprozess definieren.

- E2E-Pilot wählen: schlanker Scope mit hohem Lernwert, signifikantes Schnittstellenbild, realistische Volumina und klare Erfolgskriterien.

- Plattform befähigen: Workflow-Engine bereitstellen, Integrationsmuster katalogisieren, Test- und Rollout-Pipeline standardisieren.

- Betriebsmodell festlegen: Verantwortlichkeiten, Supportzeiten, Incident- und Change-Prozesse, Servicekatalog und Kostenstellen.

- Skalierung planen: Wiederverwendung fördern, Bausteine standardisieren, Schulungen für Fachbereiche und Entwicklung ansetzen.

- Kontinuierliche Verbesserung etablieren: Feedbackschleifen, Post-Mortems, Architektur-Reviews und KPI-basierte Priorisierung.

Der Nutzen dieses Vorgehens zeigt sich in schnelleren Durchlaufzeiten, stabileren Abläufen und geringeren Betriebsrisiken. Gleichzeitig reduzieren Sie Abhängigkeiten, weil wiederverwendbare Bausteine entstehen. Wichtig ist eine realistische Taktung: erst funktional tragfähig, dann breit ausrollen. So wächst die Lösung mit den Anforderungen.

Messbare Effekte und Steuerung

Ohne klare Messung bleibt jede Verbesserung Behauptung. Definieren Sie Kennzahlen vor dem Pilot und setzen Sie Basiswerte, um Effekte sichtbar zu machen. Wählen Sie wenige, aber aussagekräftige KPIs, die Prozessziele widerspiegeln. Verankern Sie die Messung im Betrieb, nicht nur im Projekt. So wird die Steuerung vom Projektfortschritt in den Regelbetrieb überführt und liefert eine stabile Basis für Entscheidungen.

- Durchlaufzeit: Zeit vom Eingang bis zum Abschluss eines Vorgangs, differenziert nach Hauptvarianten und Ausnahmen.

- First-Time-Right: Anteil der Vorgänge, die ohne Nacharbeit abgeschlossen werden; spiegelt Datenqualität und Prozessklarheit.

- Automatisierungsgrad: Anteil automatisiert verarbeiteter Schritte; sinnvoll je Prozessschritt und insgesamt messen.

- Fehlerrate: Anteil fehlerhafter oder zurückgewiesener Vorgänge; ideal mit Fehlerklassen zur gezielten Ursachenanalyse.

- Bearbeitungskosten: interne Aufwände pro Vorgang; Annahme: Erfassung über Zeit- und Kostensätze in definierten Stufen.

- Eskalationsquote: Anteil der Vorgänge, die definierte Schwellen überschreiten und Eingriffe erfordern.

- Mitarbeiterzufriedenheit: standardisierte, wiederkehrende Kurzbefragung zur Arbeitsentlastung und Prozessklarheit.

Verknüpfen Sie KPIs mit klaren Reaktionsmustern, etwa definierten Eskalationspfaden oder Verbesserungsmaßnahmen. Nutzen Sie Visualisierungen, die Fach- und IT-Sicht zusammenführen. Wichtig ist Konsistenz: gleiche Definitionen, gleiche Erhebungsmethoden, regelmäßige Reviews. So entstehen belastbare Trends statt Momentaufnahmen.

Risiken, Grenzen und Gegenmaßnahmen

Typische Risiken sind unklare Datenhoheit, proprietäre Lock-ins, ungeplante Lastspitzen und Lücken in Governance und Sicherheit. Ohne saubere Schnittstellen wachsen technische Schulden schnell. Fehlende Datenklassifizierung erschwert Schutzmaßnahmen und erschüttert Vertrauen. Im DACH-Umfeld kommen Pflichten wie Nachvollziehbarkeit, Betroffenenrechte und Protokollierung hinzu. Diese Risiken sind beherrschbar, wenn sie früh adressiert werden und feste Routinen erhalten.

Gegenmaßnahmen beginnen mit Architektur-Guidelines und gelebter Datenklassifizierung. Privacy-by-Default sorgt für minimale Datenverarbeitung und wirksame Kontrollen. Definieren Sie Betriebs- und Supportmodelle mit klaren Service Levels, Runbooks und Lasttests. Schulen Sie Teams in Standards, Tools und Prozessen, und begleiten Sie Veränderungen durch strukturiertes Change Management. Verträge, Datenflüsse und Speichorte sollten dokumentiert und regelmäßig überprüft werden, um DSGVO- und Sicherheitsauflagen dauerhaft zu erfüllen.

Betriebsmodell und Governance

Nachhaltige Prozessautomatisierung benötigt ein Betriebsmodell, das Rollen, Entscheidungen und Qualitätssicherung klar regelt. Prozessverantwortliche steuern fachliche Ziele, die Architektur sichert Konsistenz, und Security prüft Risiko und Kontrollen. Fachbereiche verantworten Inhalte und Tests, ein Plattformteam betreibt die Integrations- und Orchestrierungsdienste. Entscheidungsgremien priorisieren Vorhaben, managen Abhängigkeiten und sichern einheitliche Standards.

Hilfreich ist eine Definition of Done für automatisierte Prozesse: vollständige BPMN-Modelle, getestete Schnittstellen, Audit-Logs, Datenklassifizierung, Notfallverfahren und dokumentierte KPIs. So bleiben Entscheidungen nachvollziehbar, und Risiken lassen sich früh erkennen. Governance wird damit nicht zur Bremse, sondern befähigt verlässliche Abläufe.

Fazit

Mehr Werkzeuge lösen selten das Kernproblem. Integration und Orchestrierung bündeln Kräfte, schaffen Transparenz und machen Ihre Prozessautomatisierung belastbar. Starten Sie mit einer priorisierten Prozessaufnahme und einem kleinen, echten End-to-End-Piloten. Prüfen Sie Ihre Schnittstellen- und Datenstrategie und definieren Sie Metriken vor dem Roll-out. So vermeiden Sie Insellösungen, reduzieren Risiken und schaffen eine Plattform, auf der Verbesserungen zügig und kontrolliert möglich sind.