· Andreas Schwarz · Strategie & Analyse · 9 min read

Analyse ohne Overkill: Die 80/20-Regel für effiziente Prozessarbeit

Mit der 80/20-Regel lassen sich Prozesse gezielt analysieren und Optimierungspotenziale mit überschaubarem Aufwand heben ohne in Detailversessenheit zu verfallen.

Wer Prozesse effizient steuern will, muss die Balance finden: Genügend Analyse für echte Verbesserungen, aber ohne Übermaß an Detailarbeit. Prozessverantwortliche stehen häufig vor der Herausforderung, Ressourcen optimal einzusetzen und dennoch wirkungsvolle Optimierungen zu erzielen. Die 80/20-Regel bietet dafür einen pragmatischen Leitfaden, um Werthebel zu identifizieren und gezielt anzugehen. Dieser Artikel zeigt praxisnah, wie Entscheider Analyse-Overkill vermeiden, wertkritische Prozessanteile erkennen und schnelle, messbare Ergebnisse erzielen. Klar gegliederte Methoden, Tools und Handlungsempfehlungen schaffen Orientierung für die nächsten Schritte in der Prozessarbeit.

Analyse ohne Overkill: Die 80/20-Regel für effiziente Prozessarbeit

Effizient analysieren - Wertbeitrag statt Analyse-Overkill

Analysen sind unverzichtbar, wenn Prozesse verändert oder verbessert werden sollen. Doch nicht jede Prozessanalyse schafft auch Mehrwert. Wer zu viel Zeit und Energie in Detailarbeit investiert, läuft Gefahr, Ressourcen zu binden, die an anderer Stelle dringend benötigt werden. Gerade für Prozessverantwortliche stellen sich deshalb Fragen zur Tiefe und zum Zuschnitt der Analyse: Wo ist Präzision notwendig? Wo reicht eine grobe Sicht für den angestrebten Erfolg?

Viele Unternehmen und Teams kämpfen regelmäßig mit der Überfrachtung von Analyseinitiativen. Da werden unzählige Datensätze ausgewertet, jede Prozessvariante haarklein dokumentiert, Endlos-Workshops abgehalten und Verantwortliche verlieren den Fokus auf das Wesentliche. Typische Folgen: Wesentliche Schwachstellen werden aus den Augen verloren, zentrale Werttreiber geraten in den Hintergrund und die tatsächliche Umsetzung von Verbesserungen bleibt auf der Strecke.

Zielgerichtete Prozessführung erfordert die Kunst, zwischen notwendiger Tiefe und pragmatischer Schnelligkeit zu unterscheiden. Die Kunst besteht darin, messbaren Nutzen zu generieren, ohne Ressourcen zu verschwenden oder in die “Analyse-Lähmung” zu geraten. An dieser Stelle kann das Pareto-Prinzip - die 80/20-Regel - einen richtungsweisenden Rahmen bieten.

Die 80/20-Regel: Mehr Wirkung mit weniger Aufwand

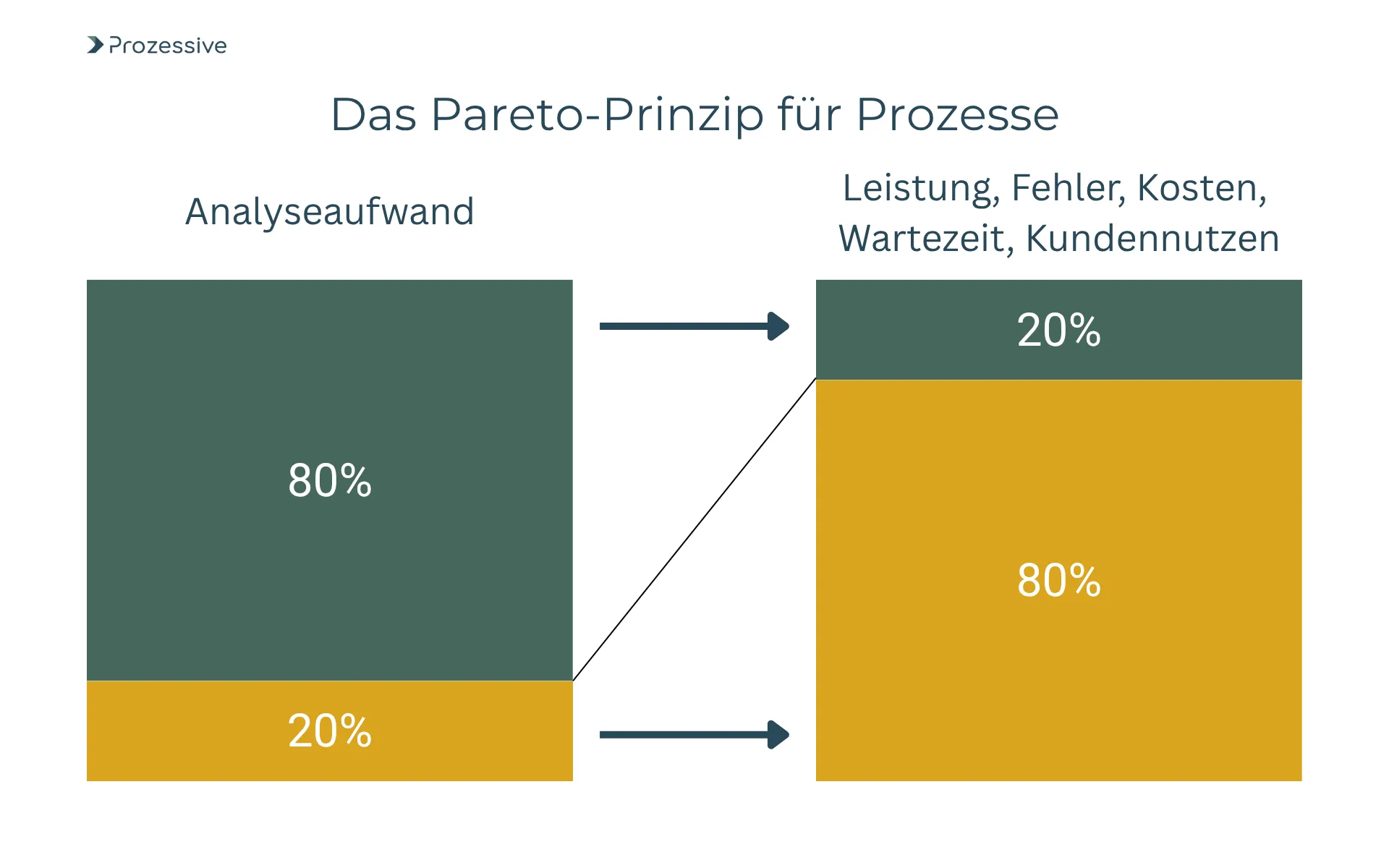

Die 80/20-Regel, auch Pareto-Prinzip genannt, besagt: In vielen Fällen werden rund 80 Prozent der Ergebnisse durch 20 Prozent des Aufwands beziehungsweise der Einflussfaktoren bestimmt. Übertragen auf die Prozessarbeit: Ein Großteil der Prozessleistung, Fehler, Kosten, Wartezeiten oder Kundenzufriedenheit lässt sich häufig auf einen kleinen Teil der Prozessschritte, Ursachen oder Beteiligten zurückführen.

Warum ist das für Prozessverantwortliche relevant? Wer die wertkritischen 20 Prozent identifiziert, kann mit überschaubarem Analyseaufwand jene Prozesskenntnisse gewinnen, die für die größten Hebel sorgen. So lassen sich Verbesserungen erzielen, ohne jeden Sonderfall oder Ausnahme zu verfolgen.

Das Pareto-Prinzip bietet damit einen Rahmen für selektive Analyse: Zuerst die offensichtlich wichtigsten Probleme und Potenziale aufdecken, dort vertiefen wo es nötig ist und unnötigen Aufwand vermeiden.

Mit dem Pareto-Prinzip lassen sich Prioritäten für Analysen und Maßnahmen setzen, was Zeit, Kosten und Energie spart und trotzdem nachhaltige Effekte ermöglicht.

Typische Fallen: Wann Analyse lähmt

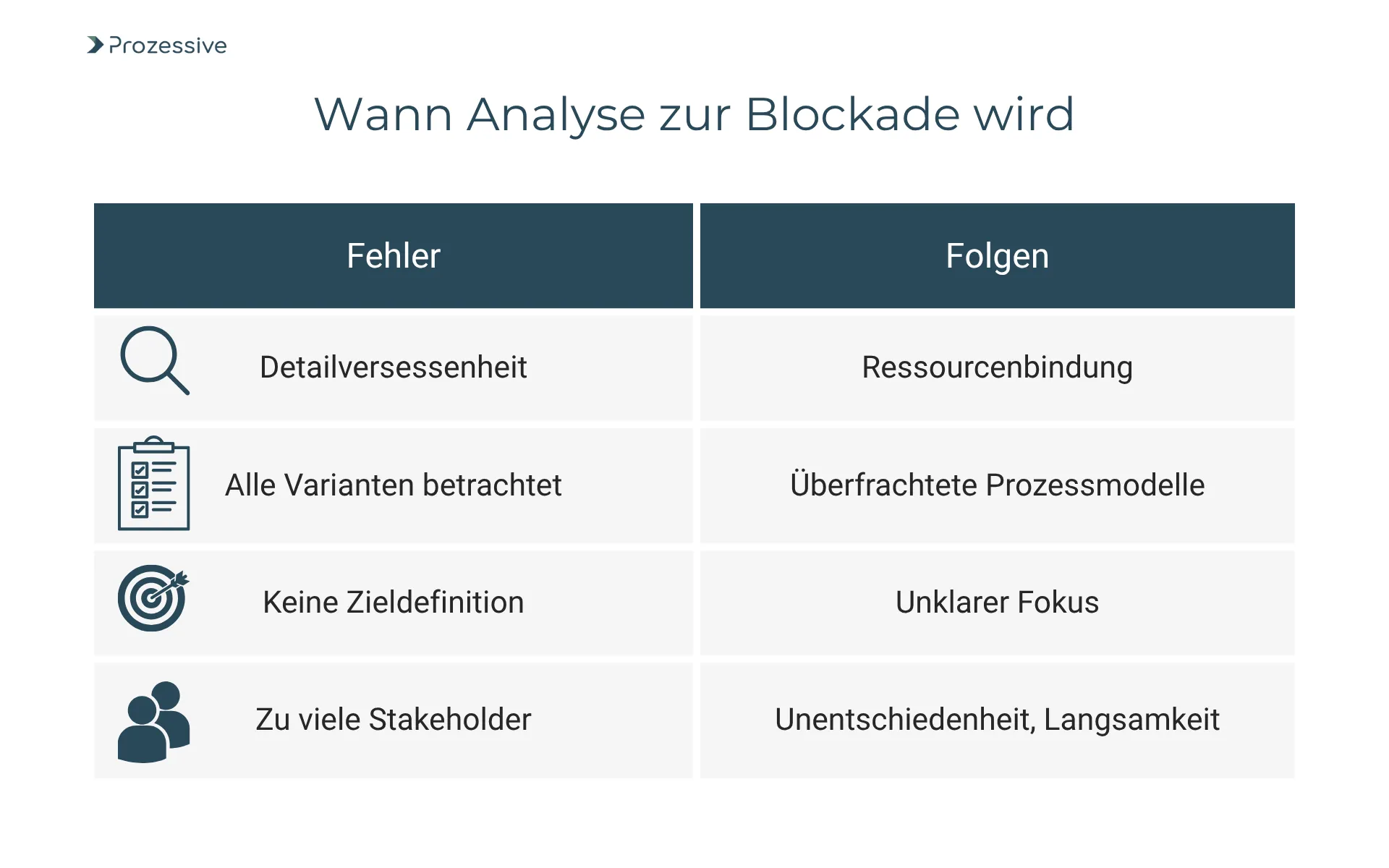

Viele Prozessverantwortliche berichten von ähnlichen Stolpersteinen im Analyseprozess:

- Die Erwartung, sämtliche Prozessdetails lückenlos zu dokumentieren

- Der Anspruch, alle Prozessvarianten zu erfassen und abzubilden

- Fehlende Zieldefinitionen und Prioritäten

- Prozesse werden mit zu vielen Stakeholdern gleichzeitig diskutiert, ohne Fokus

- Identifizierte Schwachstellen werden nicht nach Relevanz bewertet

Diese Analysefehler führen selten zu besseren Erkenntnissen, sondern oft zu überladenen Prozesslandkarten, Frust im Team und geringerer Veränderungsbereitschaft. Entscheidende Fragen geraten in den Hintergrund, während Ressourcen gebunden werden.

Wer den Analyse-Overkill aktiv vermeiden will, sollte frühzeitig Maßstäbe für Tiefe, Breite und Zielsetzung definieren. Hier bietet sich die Orientierung an Werttreibern und das Arbeiten mit klaren Entscheidungsregeln an.

Wertkritische Anteile gezielt erkennen: Anwendung der 80/20-Regel

Um das Potenzial der 80/20-Regel in der Prozessarbeit konkret nutzbar zu machen, gilt es, die wesentlichen Einflussgrößen eines Prozesses rasch zu identifizieren:

- Wertschöpfungsschritte: Welche Schritte tragen direkt zum Ergebnis bei?

- Hauptfehlerquellen/-treiber: Wo treten 80 Prozent der Fehler in 20 Prozent der Prozessschritte auf?

- Ressourcenbindung: Welche Teilprozesse beanspruchen einen Großteil von Zeit oder Kosten?

- Kunden-/Nutzerkontaktpunkte: Welche 20 Prozent der Kontaktpunkte beeinflussen 80 Prozent der Kundenzufriedenheit?

Eine erste Einschätzung ergibt sich oftmals aus einfachen Datenanalysen, der Auswertung von Tickets oder Beschwerden, oder durch gezielte Interviews mit erfahrenen Mitarbeitenden. Ergänzend bieten strukturierte Workshops, die bewusst auf die Top-Hebelpunkte abzielen, schnelle Orientierung.

Die 80/20-Regel wird so zum Kompass: Sie hilft, sich auf das Wesentliche zu konzentrieren und gezielt zu vertiefen, statt sich im Klein-Klein zu verlieren.

Kriterien und Methoden der pragmatischen Prozessaufnahme

Effiziente Prozessanalysen brauchen klare Leitplanken. Insbesondere zu Beginn lohnt sich ein pragmatisches Vorgehen:

- Definition des Analyseziels: Was soll mit der Analyse erreicht werden (z.B. Fehlerreduktion, Zeitgewinn, Kostenersparnis)?

- Vorrang für wertkritische Schritte: Fokussierung auf Prozessschritte oder Schnittstellen mit dem größten beeinflussbaren Hebel.

- Transparenz herstellen: Visualisierung von Aufwand, Zeit und Fehlerpotenzial in einfachen Modellen (z. B. Swimlane-Diagramm).

- Fehlerquellen sichtbar machen: Erheben und Spitzen darstellen, an welchen Stellen Fehler entstehen - zum Beispiel über Pareto-Charts oder einfache Häufigkeitsauswertungen.

- Automatisierungspotenziale identifizieren: Wo entstehen wiederkehrende Tätigkeiten, die mit wenig Aufwand automatisiert werden könnten?

- Iteratives Vorgehen: Analyse und Verbesserung werden als fortlaufender Lernprozess gestaltet, nicht als einmaliges Großprojekt.

Das Ziel: Möglichst schnell zu konkreten Hebeln gelangen und erst dort in die Tiefe gehen, wo das Potenzial signifikant ist.

Werkzeuge und Vorgehensmodelle für effiziente Analyse

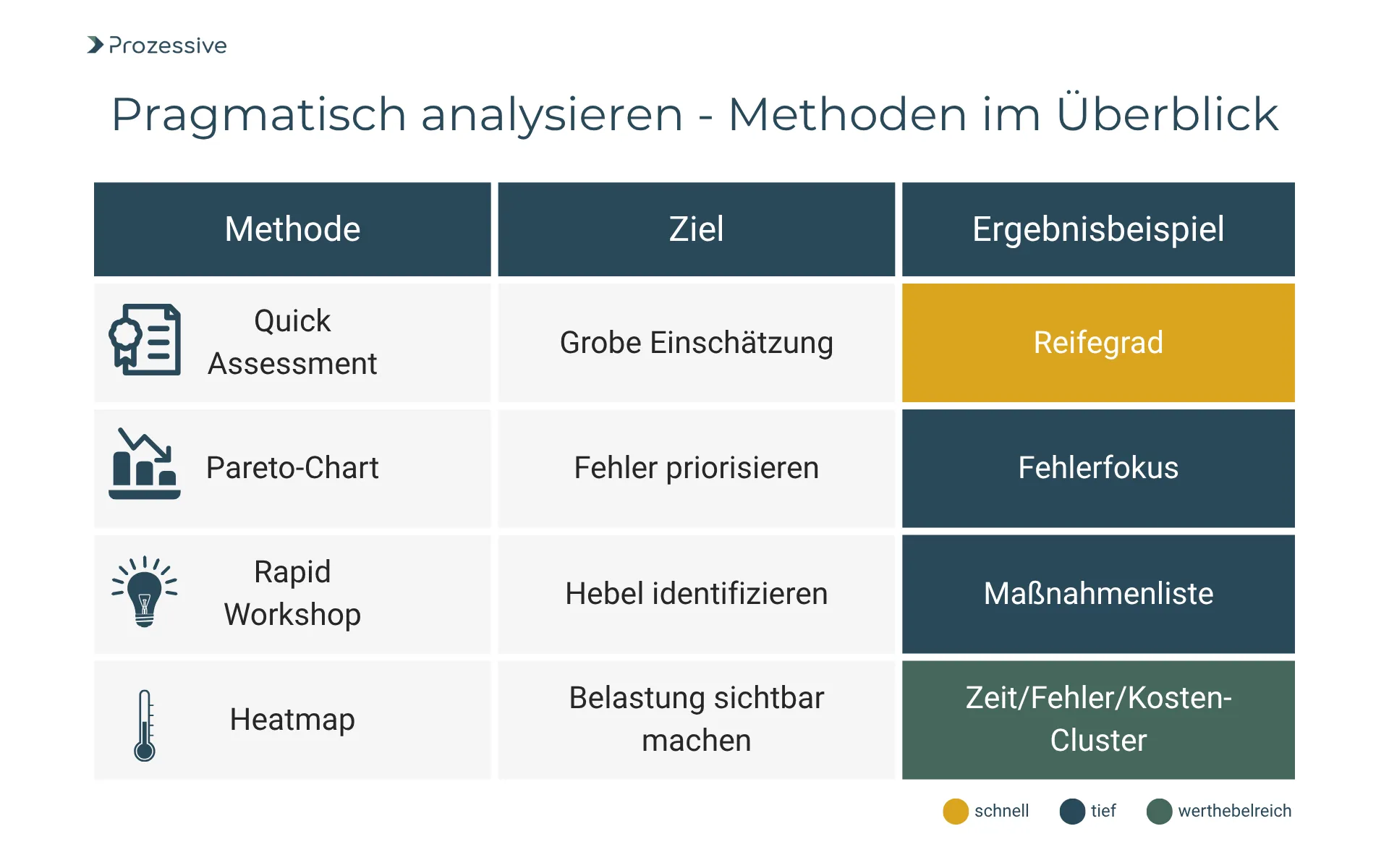

Neben traditionellen Prozessdokumentationen gibt es praxiserprobte Tools und Methoden, um die 80/20-Regel in der Analyse zu unterstützen:

| Werkzeug | Nutzen und Beschreibung |

|---|---|

| Quick Assessment | Schnelle Standortbestimmung mittels Checklisten oder Interviews |

| Pareto-Chart | Visualisiert, welche Fehler/Probleme am häufigsten auftreten |

| Rapid Improvement Workshop | Kurzworkshop, der sich gezielt den größten Werthebeln widmet |

| Heatmap | Grafische Darstellung der Belastung, Fehler oder Zeitaufwände im Prozess |

Diese Methoden fördern Transparenz und zeigen wo begrenzter Analyseeinsatz rasch zu signifikantem Fortschritt führen kann. Wichtig ist, dass dabei alle relevanten Stakeholder einbezogen werden und Entscheidungswege klar strukturiert sind.

Praxisbeispiel: Die 80/20-Regel im Einsatz

Ein mittelständisches Handelsunternehmen steht vor der Aufgabe, den Bestellabwicklungsprozess zu optimieren. Ursprünglich war geplant, sämtliche Einzelschritte, Varianten und Sonderfälle minutös zu analysieren. Nach ersten Workshops wird deutlich, dass rund 15 Prozent der Prozessschritte für knapp 80 Prozent der zeitlichen Verzögerungen und Fehlerfälle verantwortlich sind. Ursache: In diesen Schritten wurden Bestellungen häufig manuell geprüft und genehmigt, was zu Medienbrüchen, Rückfragen und verzögerten Lieferungen führte.

Das Team entscheidet, gezielt diese Prozessschritte ins Zentrum der Analyse zu rücken und auf eine vollständige Detailanalyse der Randfälle zu verzichten. Mit Unterstützung eines Pareto-Charts und einer einfachen Heatmap können die Engstellen visualisiert werden. In einem eintägigen Rapid Improvement Workshop werden die maßgeblichen Automatisierungspotenziale identifiziert und ein standardisierter Freigabeprozess mit Softwareunterstützung eingeführt.

Nutzen und Aufwand:

- Analyseaufwand im Vergleich zu einer Vollanalyse um ca. 60 Prozent reduziert

- Durchschnittliche Durchlaufzeit im Bestellprozess um 35 Prozent gesenkt

- Fehlerquote in den betroffenen Schritten halbiert

- Automatisierungsgrad im Teilprozess auf 80 Prozent erhöht

Dieses Beispiel zeigt: Fokus auf die wertkritischen 20 Prozent kann erhebliche Verbesserungen mit überschaubarem Ressourceneinsatz ermöglichen.

Tiefe versus Pragmatismus - Wie treffen Sie die richtige Entscheidung?

Nicht jeder Prozess profitiert gleichermaßen von einer ausschließlich auf die 80/20-Regel ausgerichteten Herangehensweise. Es gibt durchaus Bereiche, in denen eine tiefere Analyse unerlässlich bleibt:

- Komplexe Prozesse mit regulatorischen Anforderungen

- Hochautomatisierte, sicherheitskritische Abläufe

- Sehr stark variierende, individuell geprägte Prozesse

Entscheidungsfaktoren, ab wann eine vertiefte Analyse sinnvoll ist:

- Hohe Risiken/Eskalationspotenzial: Kann ein Fehler erhebliche Auswirkungen auf Kunden, Finanzen oder Reputation haben?

- Automatisierungskomplexität: Sind die Hebelpunkte schwer zugänglich oder technisch anspruchsvoll?

- Transparenzdefizit: Liegen bereits belastbare Daten und Erfahrungswerte vor?

- Interne/Externe Anforderungen: Gibt es Anforderungen, die eine lückenlose Dokumentation erzwingen?

In vielen Standardprozessen, insbesondere administrativen oder wiederkehrenden Routinen, ist ein pragmatischer Cut in der Analyse dagegen meist die effizientere Wahl. Entscheidend ist eine bewusste, nachvollziehbare Priorisierung von Aufwand und Nutzen.

Für viele Prozesse führen 20 Prozent gezielte Analyse zu 80 Prozent der erreichbaren Verbesserungen. Bewusstes Setzen von Analysegrenzen erhöht die Schlagkraft und Akzeptanz im Team.

Konkrete Handlungsoptionen: So starten Sie gezielt im nächsten Quartal

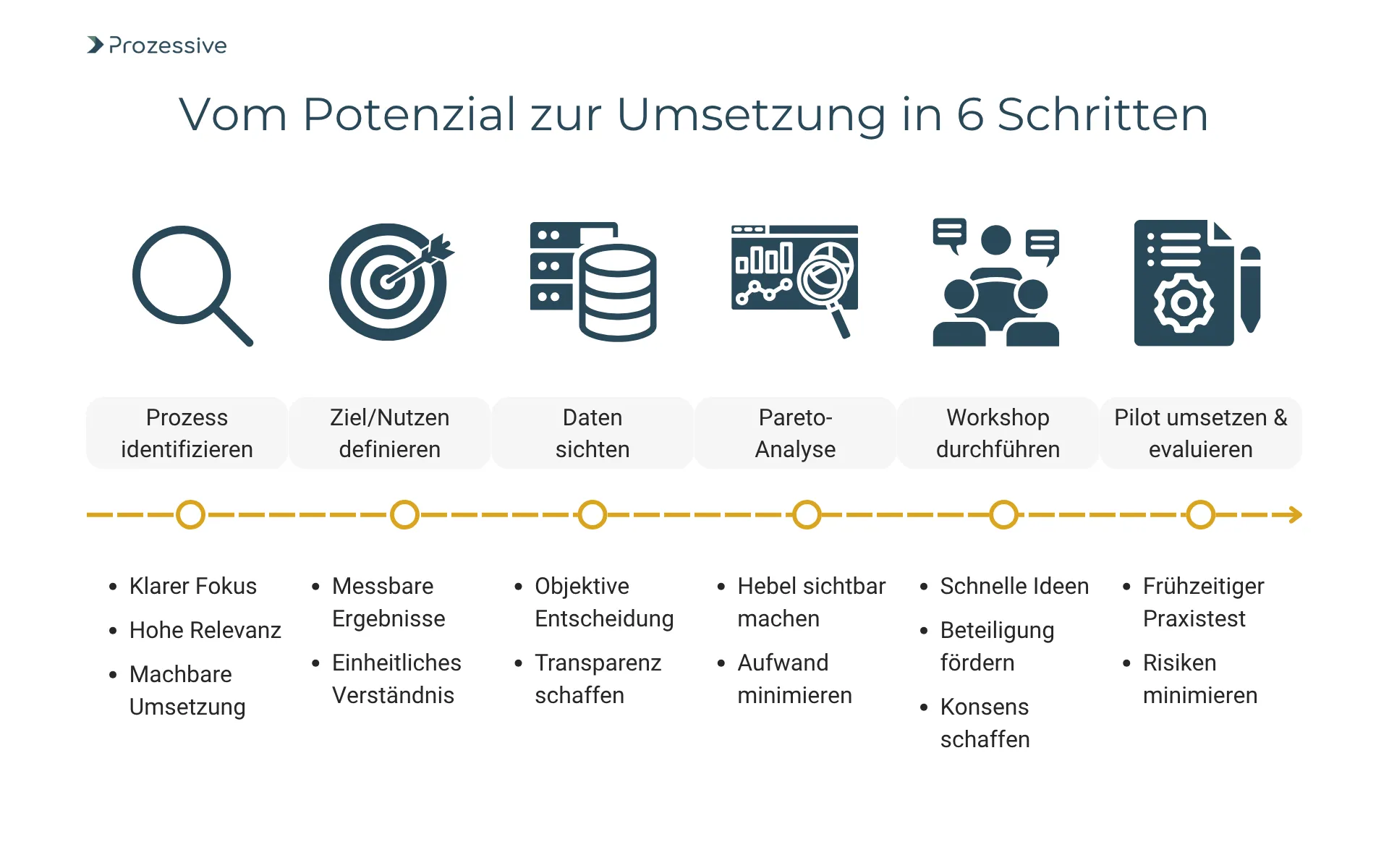

Um die beschriebenen Prinzipien in Ihrem Unternehmen umzusetzen, können folgende Schritte für den Start im nächsten Quartal empfohlen werden:

- Prozessausschnitt wählen: Identifizieren Sie einen Prozess mit sichtbarem Verbesserungspotenzial und überschaubarer Komplexität

- Ziel und Nutzen definieren: Klären Sie, welches Verbesserungsziel verfolgt wird (Zeit, Kosten, Fehler, Kundenzufriedenheit)

- Daten erheben: Nutzen Sie vorhandene Systeme oder einfache Abfragen, um die häufigsten Fehler oder Verzögerungen zu identifizieren

- Pareto-Analyse durchführen: Visualisieren Sie die Top-Hebelpunkte mit einem Pareto-Chart oder einer Heatmap

- Quick Assessment/Workshop: Bringen Sie das Team in maximal einem Tag zusammen, um gezielt Lösungen für die Hauptprobleme zu erarbeiten

- Pilot und Review: Setzen Sie eine erste Verbesserungslösung als Pilot um, bewerten Sie den Nutzen und skalieren Sie bei Erfolg

Zeitlicher Rahmen: Für einen mittleren Prozess ist mit einem Gesamtaufwand von 2-4 Wochen (einschließlich Analyse, Workshop und Umsetzung erster Maßnahmen) zu rechnen. Dies reicht in vielen Fällen für eine sichtbare Verbesserung.

Aufwand/Nutzen-Bewertung: Der Ansatz ist insbesondere in der initialen Prozessoptimierung sehr wirtschaftlich, da der Fokus auf den größten Werthebeln liegt und zeitaufwendige Detailarbeit vermieden wird.

| Schritt | Typischer Aufwand | Erwartbarer Nutzen |

|---|---|---|

| Prozessauswahl | 2-3 Tage | Hoher Fokus, Klarheit |

| Datenerhebung | 2-4 Tage | Messbarkeit, Transparenz |

| Workshop | 1 Tag | Schnelle Ergebnisfindung |

| Implementierung Pilot | 1-2 Wochen | Erlebbare Verbesserung |

Risiken und Strategien zur Risikoreduzierung

Auch ein schlanker Analyseansatz birgt Risiken, insbesondere dass relevante Details übersehen oder wichtige Prozessvarianten unzureichend beachtet werden. Folgende Strategien helfen, diese Risiken zu begrenzen:

- Stakeholder früh einbinden: Frühzeitig unterschiedliche Sichtweisen integrieren, um blinde Flecken zu vermeiden.

- Prüfpunkt nach Verbesserungsumsetzung: Nach der Umsetzung gezielt überprüfen, ob relevante Prozessdetails betroffen waren.

- Pilotierungsphase einplanen: Verändern Sie Prozesse zunächst im kleinen Maßstab, um Nebenwirkungen zu kontrollieren.

- Kritische Schnittstellen besonders prüfen: Schnittstellen mit anderen Abteilungen oder Systemen gezielt betrachten.

Mit kurzen Feedbackzyklen, klaren Erfolgskriterien und dem Einbezug aller wichtigen Stakeholder lassen sich Risiken pragmatisch beherrschen, ohne in die Detailfalle zu geraten.

Ausblick: Prozessanalyse und Automatisierung in Zeiten steigender Komplexität

Die Anforderungen an Prozessanalyse und Optimierung steigen kontinuierlich - nicht zuletzt durch die wachsende Komplexität und die fortschreitende Digitalisierung. Algorithmen und Automatisierungspotenziale machen eine Fülle von Prozessdaten besser zugänglich, fordern jedoch auch klare Prioritäten und effiziente Analyseentscheidungen.

Die 80/20-Regel bleibt dabei ein robustes Prinzip: Gerade in dynamischen Marktumfeldern liefert sie eine Orientierung für zielführende Analysen und schnelle Verbesserungen.